Traducción: Annia Domènech

Eran todavía los comienzos de la era informática, corría el año 1936, cuando el matemático Alan Turing empezó a soñar con máquinas inteligentes. Este pionero de la investigación sobre la inteligencia artificial (IA) ideó un test que, en teoría, permite determinar si una máquina puede pensar, y que tuvo gran influencia en los autores de ciencia ficción.

Isaac Asimov dejó su impronta en este tipo de literatura al imaginar un futuro poblado por seres mecánicos no sólo inteligentes, sino también emocionales. Igualmente inspirado por el test de Turin, Philip K. Dick, escribió ¿Sueñan los androides con ovejas eléctricas? En la película Blade Runner, basada en este relato, los Replicantes son robots con una apariencia humana perfecta, pero cuya capacidad de sentir emociones es puesta en tela de juicio.

La realidad no ha sido capaz, al menos todavía, de atrapar a la ficción, pero se ha recorrido una parte significativa del camino: desde el libro La sociedad del espíritu, de Marvin Minsky, uno de los primeros en proponer soluciones reales de IA, hasta la construcción de Big Blue, el ordenador que pudo ganar al campeón mundial de ajedrez. Algunos de los intentos realizados con el fin de obtener IA se han inspirado directamente en la observación de fenómenos naturales, como los algoritmos genéticos o las redes neuronales. En 1957, Franck Rosenblatt propuso el perceptrón, un modelo de red artificial de neuronas.

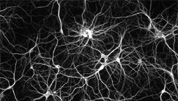

La neurona biológica está formada por diferentes regiones (dendritas, soma y axón), cada una con una función precisa. Las dendritas son prolongaciones protoplasmáticas cuyo trabajo consiste en registrar los cambios locales de potencial (señal eléctrica) provocados por las sinapsis, que son uniones especializadas con otras neuronas. La amplitud de cada potencial se modera según su localización sobre la parte dendrítica.

Todos los potenciales son integrados en el soma, la parte central de la neurona, y como resultado se emite o no un potencial que se propaga a través del axón hasta las sinapsis con otras células. De este modo la información es transmitida de unas neuronas a otras. La organización neuronal en el cerebro constituye una red muy compleja que permite tratar los datos procedentes de los órganos sensoriales del cuerpo (por ejemplo, los ojos observando un vaso de agua), y reenviar respuestas adecuadas a los órganos motores (los músculos del brazo y la mano para coger el vaso de agua).

Las neuronas artificiales nacieron por analogía con las células nerviosas: cada parte de la neurona artificial se modela informáticamente para reproducir el comportamiento celular, y la señal nerviosa se traduce a un valor numérico real. Las sinapsis transmiten los valores de entrada de cada neurona, y se representan en forma de vector (x0, ...xN), siendo N el número de sinapsis conectadas a la neurona. Cada neurona artificial tiene también un axón que transmite un valor único de salida y. Las dendritas, polos receptores, se modelan por el "peso" en el mismo número que las entradas: cada peso wi se aplica a una entrada xi. El peso es un factor multiplicador que permite modificar la importancia del valor de entrada. A la zona de integración (el soma) se le atribuye una función de activación que transforma la suma de las entradas en un valor de salida. La fórmula se escribe: y = f(ΣN wi xi)

¿En qué se traduce todo esto? La función de activación juega un rol básico en el funcionamiento de la neurona artificial, ya que determina si la señal tiene que "seguir camino" (ser transmitida) o no. Hay diferentes tipos de funciones, la más utilizada es una que se llama sigmoidea: si la suma ponderada de las entradas es muy pequeña, la señal no es transmitida; si es muy grande, sí. Actúa de forma progresiva, con una zona de transición para los valores intermedios que permite generar una señal con una intensidad variable. Existen otras funciones de activación, por ejemplo la gaussiana transmite la señal cuando la suma ponderada de las entradas no es ni muy pequeña ni muy grande.

Una vez se ha realizado un modelo individual para la neurona, hay que lograr la comunicación inteligente entre varias de ellas. Una de las construcciones más conocidas para las redes de neuronas artificiales es el llamado perceptrón multicapas: las capas de neuronas se transmiten la información en un solo sentido. Cada neurona de una capa está conectada a todas las de la siguiente. Dicha organización se reproduce hasta llegar a la última capa, donde las salidas de todas las neuronas constituyen la salida múltiple de la red.

¿Cómo utilizar este sistema para avanzar en el conocimiento? En el cerebro, una neurona posee una regionalización de sus funciones por las diferentes propiedades de la membrana plasmática en cada una de sus partes. La compartimentación biológica se reproduce en las neuronas artificiales ajustando sus pesos. El ajuste de pesos se hace "alimentando" la red, es decir, enseñándole cómo reconocer los ejemplos. Aquí también puede realizarse una analogía con el esquema de aprendizaje del ser humano el cual, a partir de casos particulares que le sirven de ejemplo, extrae un conocimiento general. En IA, con cada nuevo ejemplo, la red ajustará el valor de los pesos de cada neurona para que las señales de entrada (como los ojos observando un vaso de agua), una vez atravesada la red, correspondan al resultado esperado (activar los músculos adecuados para coger el vaso). Cuanto mayor sea el número de ejemplos, más aprenderá la red y más capaz será de generalizar sus conocimientos. Una vez "enseñada", se le puede dar a la red un caso desconocido, y a partir de lo que ha aprendido antes dará la respuesta que le parezca mejor. ¡Y funciona!

Veamos un ejemplo de aplicación para comprender mejor cómo actúa un perceptrón multicapas: el reconocimiento de la firma. Para entrenar a la red, se le pide a una persona que firme varias veces y se asocia a cada una de las imágenes un valor de reconocimiento positivo. Después se pide a otras personas que intenten imitar dicha firma y se atribuye a sus firmas un reconocimiento negativo. Esto es una base de aprendizaje. Una imagen de la firma mide 25x25 píxeles. Se crea un perceptrón 625-312-1 que toma como entrada todos los píxeles de la imagen y como salida única el valor del reconocimiento: 1 cuando la firma es reconocida, 0 cuando no. El sistema aprende a partir de todos los ejemplos a reconocer únicamente la escritura deseada.

Existen muchas aplicaciones de las redes neuronales, tanto en la industria como en la investigación científica: el reconocimiento de la firma, del que hemos hablado, la conducción automática de un coche mediante el análisis de las imágenes del camino, la predicción del futuro de la bolsa a partir del pasado, la lectura en voz alta de textos, los diagnósticos médicos a partir de los conocimientos de expertos, la detección automática de movimientos de tierras en imágenes tomadas por satélite, la diferenciación entre estrellas y galaxias en las imágenes de un telescopio… Los resultados obtenidos son excelentes en la mayoría de los casos. Esto confirma la capacidad de los perceptrones multicapas de aprender a partir de la experiencia realizando una combinación compleja de señales. Sin embargo, las herramientas de IA tienen una limitación. Mientras que existen miles de millones de neuronas en el cerebro humano, los perceptrones están con frecuencia limitados a unas decenas o centenas de ellas. El tiempo requerido para el aprendizaje de miles de millones de neuronas sería de decenas de años… el mismo que para el ser humano.

Multimedia

-

Intentando copiar el cerebro humano

Intentando copiar el cerebro humanoEl reconocimiento de una firma utilizando una red de neuronas artificiales

Autor: Anthony Baillard

© caosyciencia.com

El autor

Anthony Baillard es Ingeniero Informático y Doctor en tratamiento de imágenes e inteligencia artificial.

Ver todos los artículos de Anthony Baillard

Glosario

-

Estrella

-

Galaxias